強化学習とディープラーニングの関係性とは?AI技術の基礎から実用例まで徹底解説

2025.12.22

近年のAI技術の進化は目覚ましく、自動運転やゲームAI、ロボット制御など、さまざまな分野で実用化が進んでいます。その背景には「強化学習」や「ディープラーニング」といった機械学習技術の発展があります。 しかし、これらの用語は専門的で混同されやすく、「強化学習とディープラーニングの違いは何か」「どのように関連しているのか」といった疑問を持つ方も多いでしょう。 本記事では、強化学習とディープラーニングの基礎から両者の関係性、そして実際の活用事例まで、AI開発に携わる方にもわかりやすく解説します。

- 強化学習とは

- 強化学習が持つ独自の学習メカニズム

- 強化学習を構成する5つの要素

- 報酬の最大化を目指す学習プロセス

- ディープラーニングとは?

- ニューラルネットワークによる特徴抽出の自動化

- ディープラーニングが得意とする領域と技術的特徴

- 強化学習とディープラーニングの違い

- 学習における人間の関与度の差

- データの扱い方と学習目標の相違

- 適用される問題領域と実装上の特徴

- 強化学習の機械学習全体における位置づけ

- 教師あり学習

- 教師なし学習

- 強化学習

- 深層強化学習とは?2つの技術を融合したアプローチ

- 深層強化学習が生まれた背景と必要性

- ニューラルネットワークによる状態価値の推定

- DQN(Deep Q-Network)などの代表的アルゴリズム

- ディープラーニング導入時の課題と対応策

- 学習に必要な計算リソースと時間コストがかかる

- 報酬設計が複雑になりやすい

- シミュレーション環境の構築が必須である

- 専門知識と開発体制の整備が欠かせない

- まとめ

強化学習とは

強化学習は、エージェント(学習主体)が環境との相互作用を通じて、試行錯誤しながら最適な行動を学習する機械学習の手法です。

- 強化学習が持つ独自の学習メカニズム

- 強化学習を構成する5つの要素

- 報酬の最大化を目指す学習プロセス

強化学習が持つ独自の学習メカニズム

強化学習は、他の機械学習手法とは異なる独自の学習メカニズムを持っています。教師あり学習のように「正解」が事前に用意されているわけではなく、エージェント自身が行動を選択し、その結果得られる報酬をもとに学習を進めます。

この学習方法は、人間や動物が試行錯誤を通じてスキルを獲得する過程に似ています。たとえば、子どもが自転車の乗り方を学ぶ際、最初は何度も転びながらバランスの取り方を体得していきます。強化学習のエージェントも同様に、失敗と成功を繰り返しながら、より良い行動パターンを身につけていくのです。

強化学習の最大の特徴は、長期的な報酬の最大化を目指す点にあります。目先の利益だけでなく、将来得られる報酬も考慮に入れた意思決定をおこないます。この特性により、複雑な戦略的判断が必要な問題に対しても有効なアプローチとなっています。

強化学習を構成する5つの要素

強化学習は、以下の5つの基本要素で構成されます。これらの要素が相互に作用することで、学習プロセスが成立します。

エージェント(学習主体)は、環境の中で行動を選択し、学習をおこなう主体です。ゲームAIであれば、プレイヤーを操作するAIシステムがエージェントにあたります。ロボット制御であれば、ロボット自体が該当するといえるでしょう。

残りの4つの要素は以下のとおりです。

| 要素 | 概要 | 具体例 |

| 環境 | エージェントが相互作用する対象。エージェントの行動に応じて変化し、新しい状態と報酬を返す | 囲碁やチェスのようなゲームであれば、盤面全体が環境となる |

| 状態 | ある時点における環境の状況を表す。エージェントは、この状態を観測して次の行動を決定する | 自動運転であれば、周囲の車両の位置、道路の状況、信号機の色などが状態に含まれる |

| 行動 | エージェントが環境に対して実行する選択肢 | ロボットアームの制御であれば、「上に動かす」「下に動かす」「つかむ」といった具体的な動作が行動にあたる |

| 報酬 | エージェントの行動に対して環境から与えられるフィードバック。望ましい行動には正の報酬、望ましくない行動には負の報酬(ペナルティ)が与えられる | この報酬シグナルが、エージェントの学習を導く重要な指針となる |

報酬の最大化を目指す学習プロセス

強化学習の目標は、長期的に得られる報酬の総和を最大化する行動方策を見つけることです。この学習プロセスは、エージェントが環境との相互作用を繰り返すことで進行します。

学習の初期段階では、エージェントはランダムに近い行動を取ります。しかし、試行を重ねるにつれて、どの状態でどの行動を取れば高い報酬が得られるかを学習していきます。この過程で重要なのが「探索と活用のトレードオフ」です。

探索とは、まだ試していない新しい行動を試みることを指します。一方、活用とは、これまでの経験から高い報酬が期待できる行動を選択することです。効果的な学習をおこなうには、この2つのバランスを適切に保つ必要があります。

また、強化学習では「遅延報酬」の問題にも対処する必要があります。ある行動の結果が即座に現れるとは限らず、数手先になってようやく報酬として現れることもあります。たとえばチェスでは、序盤の一手が終盤の勝敗に影響を与えることがあるでしょう。こうした長期的な影響を考慮した学習が、強化学習の重要な特徴となっています。

ディープラーニングとは?

ディープラーニングは、多層のニューラルネットワークを用いて、データから自動的に特徴を抽出し学習する機械学習の手法です。

- ニューラルネットワークによる特徴抽出の自動化

- ディープラーニングが得意とする領域と技術的特徴

ニューラルネットワークによる特徴抽出の自動化

ディープラーニングの最大の特徴は、人間が手動で特徴量を設計する必要がなく、データから自動的に有用な特徴を抽出できる点にあります。

従来の機械学習では、専門家がデータの特徴を手動で設計する必要がありました。たとえば、画像認識では「エッジの方向」「色の分布」といった特徴量を人間が定義していました。しかし、ディープラーニングでは、多層のニューラルネットワークが自動的にこれらの特徴を学習します。

ニューラルネットワークは、脳の神経細胞の構造を模した計算モデルです。入力層、複数の中間層(隠れ層)、出力層から構成され、各層は多数のニューロン(ノード)で構成されています。各ニューロンは前の層から信号を受け取り、重み付けをおこない、活性化関数を通して次の層に伝達します。

学習プロセスでは、大量のラベル付きデータを用いて、ネットワークの重みパラメータを調整します。この過程で、浅い層では単純なパターン(画像であれば線や角)を捉え、深い層ではより複雑で抽象的な特徴(物体の形状や概念)を捉えるようになります。この階層的な特徴抽出が、ディープラーニングの強力な表現能力の源泉です。

ディープラーニングが得意とする領域と技術的特徴

ディープラーニングは、特に画像認識、音声認識、自然言語処理といった分野で飛躍的な性能向上を実現しました。

画像認識の分野では、CNN(畳み込みニューラルネットワーク)が広く使われています。CNNは画像の局所的な特徴を効率的に捉える構造を持ち、物体検出や顔認識などで高い精度を達成しています。医療画像診断では、専門医に匹敵する精度で病変を検出できるようになりました。

自然言語処理では、RNN(再帰型ニューラルネットワーク)やTransformerといったアーキテクチャが発展し、機械翻訳や文章生成の品質が大幅に向上しています。近年のGPTやBERTといった大規模言語モデルは、ディープラーニング技術の進化を象徴する成果といえるでしょう。

ただし、ディープラーニングには大量の学習データと計算リソースが必要です。また、学習済みモデルの判断根拠が不透明な「ブラックボックス問題」も指摘されています。これらの課題を理解したうえで、適切に活用することが重要です。

強化学習とディープラーニングの違い

強化学習とディープラーニングは、学習の仕組みや目的が大きく異なります。

- 学習における人間の関与度の差

- データの扱い方と学習目標の相違

- 適用される問題領域と実装上の特徴

学習における人間の関与度の差

強化学習とディープラーニングの最も大きな違いは、学習における人間の関与度にあります。

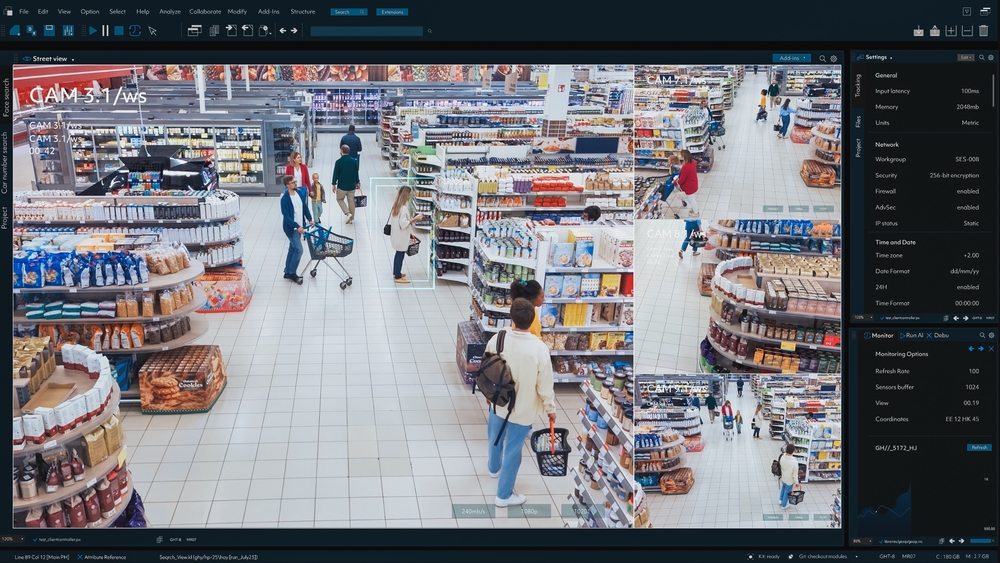

ディープラーニングを含む教師あり学習では、人間が事前にラベル付けした正解データを大量に用意する必要があります。たとえば、猫の画像認識をおこなう場合、数万枚の画像に対して「これは猫」「これは猫ではない」というラベルを人間が付与します。このアノテーション作業には、相当な時間とコストがかかります。

一方、強化学習では正解データの用意は不要です。エージェント自身が環境と相互作用しながら、報酬シグナルをもとに試行錯誤を通じて学習します。人間が設定するのは、報酬関数(どのような行動が望ましいか)だけです。

この違いは、適用可能な問題領域にも影響を与えます。正解が明確に定義できる問題にはディープラーニングが適していますが、正解が一意に定まらない問題や、長期的な戦略が必要な問題には強化学習が有効です。

データの扱い方と学習目標の相違

データの扱い方と学習目標においても、両者には明確な違いがあります。

ディープラーニングは、静的なデータセットから学習をおこないます。学習データは事前に収集され、固定されたものです。学習の目標は、入力データに対して正しい出力を予測することです。たとえば、画像分類では「この画像には何が写っているか」を正確に判定することが目標となります。

対照的に、強化学習では動的なデータ生成がおこなわれます。エージェントが環境と相互作用する過程で、新しいデータが継続的に生成されます。学習の目標は、長期的な報酬の総和を最大化する行動方策を獲得することです。

また、ディープラーニングでは各データサンプルが独立していると仮定されますが、強化学習では過去の行動が現在の状態に影響を与えるため、時系列的な依存関係が存在します。この違いにより、強化学習では「信用割当問題」と呼ばれる課題が生じます。これは、過去のどの行動が最終的な報酬に貢献したのかを特定する必要があるという問題です。

適用される問題領域と実装上の特徴

問題領域と実装の観点からも、両者には特徴的な違いが見られます。

ディープラーニングは、パターン認識や予測といった問題に適した手法です。画像認識、音声認識、異常検知、需要予測など、入力に対する出力が比較的明確な問題で高い性能を発揮します。実装においては、学習データの品質と量が性能を大きく左右します。

強化学習は、意思決定や制御といった問題に適しています。ゲームAI、ロボット制御、自動運転、資源配分の最適化など、連続的な意思決定が必要な問題で力を発揮します。実装においては、報酬関数の設計とシミュレーション環境の構築が重要となります。

また、学習の安定性にも違いがあります。ディープラーニングは比較的安定した学習が可能ですが、強化学習は学習が不安定になりやすく、収束までに時間がかかることがあります。適切なハイパーパラメータの設定や、学習アルゴリズムの選択が成功の鍵を握ります。

強化学習の機械学習全体における位置づけ

機械学習は、学習方法の違いによって大きく3つに分類されます。

- 教師あり学習

- 教師なし学習

- 強化学習

教師あり学習

教師あり学習は、入力データと正解ラベルのペアを用いて学習をおこなう手法です。機械学習の中で最も広く実用化されており、ディープラーニングの多くもこのカテゴリに含まれます。

具体的には、分類問題と回帰問題の2種類があります。分類問題では、入力データを事前に定義されたカテゴリに分類します。スパムメールの判定、画像の物体認識、顧客の離反予測などが該当します。回帰問題では、連続値の予測をおこないます。不動産価格の予測、需要予測、気温予測などがこれにあたります。

教師あり学習の利点は、明確な目標に対して高い精度を達成できる点です。ただし、大量のラベル付きデータが必要であり、そのアノテーション作業にコストがかかることが課題となります。

教師なし学習

教師なし学習は、ラベルのないデータからパターンや構造を発見する手法です。正解が与えられないため、データの内在する特徴を自動的に抽出します。

代表的な手法には、クラスタリングと次元削減があります。クラスタリングは、類似したデータをグループ化する手法で、顧客セグメンテーションや異常検知などに活用されます。次元削減は、高次元データを低次元に圧縮しながら重要な情報を保持する手法で、データの可視化や前処理に用いられます。

教師なし学習は、ラベル付けのコストを削減できる点が大きな利点です。また、人間が気づかないパターンを発見できる可能性もあります。ただし、発見されたパターンの解釈には専門知識が必要となることがあります。

強化学習

強化学習は、前述のとおり、エージェントが環境との相互作用を通じて試行錯誤しながら学習する手法です。

教師あり学習や教師なし学習と比較すると、強化学習は「行動を通じて環境に影響を与え、その結果をもとに学習する」という点で根本的に異なります。この特性により、動的で複雑な意思決定問題に対応できます。

3つの学習方法は、問題の性質に応じて使い分けられます。実際のAI開発プロジェクトでは、これらを組み合わせたハイブリッドアプローチも活用されています。たとえば、強化学習とディープラーニングを融合した「深層強化学習」は、複雑な問題に対する強力なソリューションとなっています。

深層強化学習とは?2つの技術を融合したアプローチ

深層強化学習は、強化学習とディープラーニングを組み合わせた手法です。

- 深層強化学習が生まれた背景と必要性

- ニューラルネットワークによる状態価値の推定

- DQN(Deep Q-Network)などの代表的アルゴリズム

深層強化学習が生まれた背景と必要性

従来の強化学習には、状態空間が大きくなると学習が困難になるという課題がありました。たとえば、囲碁の盤面の状態数は天文学的な数に上り、すべての状態を記憶して学習することは現実的ではありません。

この問題を解決するために登場したのが深層強化学習です。ディープラーニングの強力な表現能力を活用することで、膨大な状態空間を効率的に扱えるようになりました。

深層強化学習は、2015年にDeepMindが発表したDQNによって注目を集めました。DQNは、Atariのビデオゲームを人間以上のレベルでプレイできることを実証し、AI研究における大きなブレークスルーとなりました。その後、AlphaGoが世界トップレベルのプロ棋士に勝利したことで、深層強化学習の可能性が広く認識されるようになったのです。

ニューラルネットワークによる状態価値の推定

深層強化学習では、ニューラルネットワークを用いて、状態の価値や行動の価値を推定します。

従来の強化学習では、状態価値をテーブルに記憶していました。しかし、状態空間が大きい場合、この方法は実用的ではありません。深層強化学習では、ニューラルネットワークを関数近似器として使用し、未経験の状態に対しても価値を推定できるようにします。

具体的には、状態を入力として受け取り、その状態でどれくらいの報酬が期待できるか(状態価値)、あるいは各行動を取った場合にどれくらいの報酬が期待できるか(行動価値)を出力するネットワークを学習します。この近似により、限られた経験から効率的に学習をおこなえるようになります。

また、画像を直接入力として扱える点も重要です。従来の手法では、画像から特徴量を手動で抽出する必要がありましたが、深層強化学習では畳み込みニューラルネットワークを使用することで、生の画像データから直接学習できます。

DQN(Deep Q-Network)などの代表的アルゴリズム

深層強化学習には、さまざまなアルゴリズムが開発されています。代表的なものを以下に紹介します。

| アルゴリズム | 概要 | 特徴 |

| DQN(Deep Q-Network) | Q学習とディープラーニングを組み合わせた手法 | 経験再生とターゲットネットワークという2つの技術的工夫により、学習の安定化を実現 |

| A3C(Asynchronous Advantage Actor-Critic) | 複数のエージェントを並列に動作させることで、学習を高速化する手法 | Actor-Criticアーキテクチャを採用し、方策と価値関数を同時に学習する |

| PPO(Proximal Policy Optimization) | 方策の更新幅を制限することで、学習の安定性を高めた手法 | 実装がシンプルでありながら高い性能を示すため、現在では広く使用されている |

これらのアルゴリズムは、問題の特性に応じて選択されます。ゲームAIやロボット制御など、さまざまな分野で実用化が進んでいます。

ディープラーニング導入時の課題と対応策

深層強化学習を実際に導入する際には、いくつかの課題に直面します。

- 学習に必要な計算リソースと時間コストがかかる

- 報酬設計が複雑になりやすい

- シミュレーション環境の構築が必須である

- 専門知識と開発体制の整備が欠かせない

学習に必要な計算リソースと時間コストがかかる

深層強化学習は、膨大な計算リソースと学習時間を必要とします。ディープラーニングと強化学習の両方の計算コストが重なるため、通常のディープラーニングよりもさらに多くのリソースが必要です。

たとえば、AlphaGoの学習には数千個のGPUと数週間の時間が必要でした。こうした大規模な計算リソースは、多くの企業にとって大きな負担となります。

対応策としては、事前学習済みモデルの活用や、転移学習の適用が考えられます。また、学習を効率化するアルゴリズムの選択や、ハイパーパラメータの適切な調整も重要です。クラウドコンピューティングサービスを活用することで、必要な時だけリソースを確保する方法も有効です。

報酬設計が複雑になりやすい

報酬関数の設計は、強化学習の成否を決める重要な要素ですが、適切に設計することは容易ではありません。

報酬設計が不適切だと、エージェントは意図しない行動を学習してしまいます。たとえば、ロボットに「速く移動する」という報酬を与えると、転倒を繰り返しながらも速度だけを追求する行動を学習する可能性があります。

こうした問題を「報酬ハッキング」と呼びます。エージェントは、設計者の意図とは異なる方法で報酬を最大化しようとすることで、意図と異なる内容を学習することがあります。

対応策としては、複数の観点から報酬を設計する、中間的な報酬を適切に与える、人間のフィードバックを組み込むといった方法が一般的です。また、逆強化学習という手法を使い、人間の行動から報酬関数を自動的に学習させるアプローチも研究されています。

シミュレーション環境の構築が必須である

強化学習では、エージェントが大量の試行錯誤をおこなう必要があります。現実世界でこれを実施するのは、時間的にもコスト的にも現実的ではありません。

そのため、多くの場合、シミュレーション環境での学習が必須となります。しかし、現実世界を正確に再現したシミュレーション環境を構築することは、技術的に困難です。

また、シミュレーション環境で学習したエージェントを現実世界に適用する際、環境の違いにより性能が低下する「Sim-to-Realギャップ」という問題も発生します。

対応策としては、できるだけ現実に近い物理シミュレーションを使用する、ドメインランダマイゼーションという手法でシミュレーション環境に多様性を持たせる、現実世界でのファインチューニングをおこなうといった方法が考えられます。

専門知識と開発体制の整備が欠かせない

深層強化学習の導入には、機械学習、強化学習、ディープラーニング、ソフトウェア工学など、幅広い専門知識が必要です。

アルゴリズムの選択、ネットワークアーキテクチャの設計、ハイパーパラメータの調整、学習の安定化など、多岐にわたる技術的判断が求められます。これらの判断には、理論的な理解だけでなく、実践的な経験も重要です。

また、学習の監視と評価、デバッグ、本番環境への展開といった開発プロセス全体を管理する体制も必要です。

対応策としては、専門人材の採用や育成、外部の専門企業との協業、段階的な導入アプローチの採用などが考えられます。小規模なプロジェクトから始めて、徐々に知見を蓄積していくことが現実的です。

まとめ

強化学習とディープラーニングは、それぞれ異なる特性と強みを持つ機械学習技術です。強化学習は試行錯誤を通じて最適な行動を学習する手法であり、ディープラーニングはデータから自動的に特徴を抽出する手法です。

両者を融合した深層強化学習は、複雑な意思決定問題に対する強力なアプローチとなっています。ゲームAI、ロボット制御、自動運転など、さまざまな分野で実用化が進んでおり、今後さらなる発展が期待されます。

ただし、導入には計算リソース、報酬設計、シミュレーション環境の構築、専門知識の確保といった課題があります。これらの課題に適切に対処しながら、段階的に取り組むことが成功の鍵となるでしょう。AI技術の進化は急速ですが、基礎となる概念や手法を理解することで、自社のビジネスに最適な活用方法を見出せるはずです。